Grote taalmodellen zoals ChatGPT hebben talloze toepassingen, van e-mails opstellen en teksten samenvatten tot computercode ontwikkelen. Dat is ook criminelen niet ontgaan. Ze gebruiken de technologie onder andere om overtuigende phishingmails te schrijven en geavanceerde malware te ontwikkelen.

Koen Vervloesem

ChatGPT (https://chat.openai.com) heeft volgens maker OpenAI (https://openai.com) wereldwijd 100 miljoen actieve gebruikers, dat wil zeggen mensen die de AI-chatbot wekelijks gebruiken. Bedrijven zetten ChatGPT in voor uiteenlopende taken, van teksten schrijven en over ideeën brainstormen tot documenten samenvatten. Steeds meer werknemers leren hoe ze zich in hun dagelijkse taken kunnen laten ondersteunen door AI-chatbots.

Er wordt uiteraard nog heel wat geëxperimenteerd, want ChatGPT is nog vrij nieuw en de mogelijkheden en beperkingen zijn nog niet heel duidelijk. Maar dat heeft cybercriminelen er niet van weerhouden om ook al de mogelijkheden van grote taalmodellen te verkennen. Ondertussen hebben heel wat cybercriminelen al AI aan hun gereedschapskist toegevoegd.

Overtuigende phishingmails

We kennen allemaal de phishingmails in gebrekkig Nederlands, die ons proberen te overtuigen om op een website in te loggen die van onze bank lijkt te zijn. Maar wie zo’n mail een beetje aandachtig leest, merkt vaak wel op dat het taalgebruik niet past bij een bank of dat er iets niet klopt aan wat er wordt gevraagd.

Cybercriminelen ontdekten al snel dat ze een AI-model heel overtuigende phishingmails kunnen laten schrijven, en dat tegen een heel lage kostprijs. Uit onderzoek van IBM X-Force blijkt overigens dat slachtoffers nog altijd meer klikken op phishingmails die door mensen zijn geschreven dan hun evenknieën die van ChatGPT afkomstig zijn. Maar als je bedenkt dat het een team beveiligingsonderzoekers met ervaring in social engineering maar liefst 16 uur kostte om een gepersonaliseerde phishingmail te perfectioneren, en dat een AI-model hiervoor slechts vijf minuten nodig had, wordt duidelijk waar het gevaar van AI-modellen ligt: ze verlagen aanzienlijk de drempel voor phishing.

Dankzij AI-modellen hoef je nu geen talenknobbel of moedertaalspreker meer te zijn om foutloze phishingmails op te stellen. Sterker nog, je kunt zelfs perfect phishingmails laten genereren in een taal die je zelf niet eens beheerst. Dat maakt het zelfs voor aanvallers met beperkte taalvaardigheid mogelijk om grootse phishingcampagnes op te zetten.

|

|

Cybercriminelen gebruiken AI om phishingmails te schrijven |

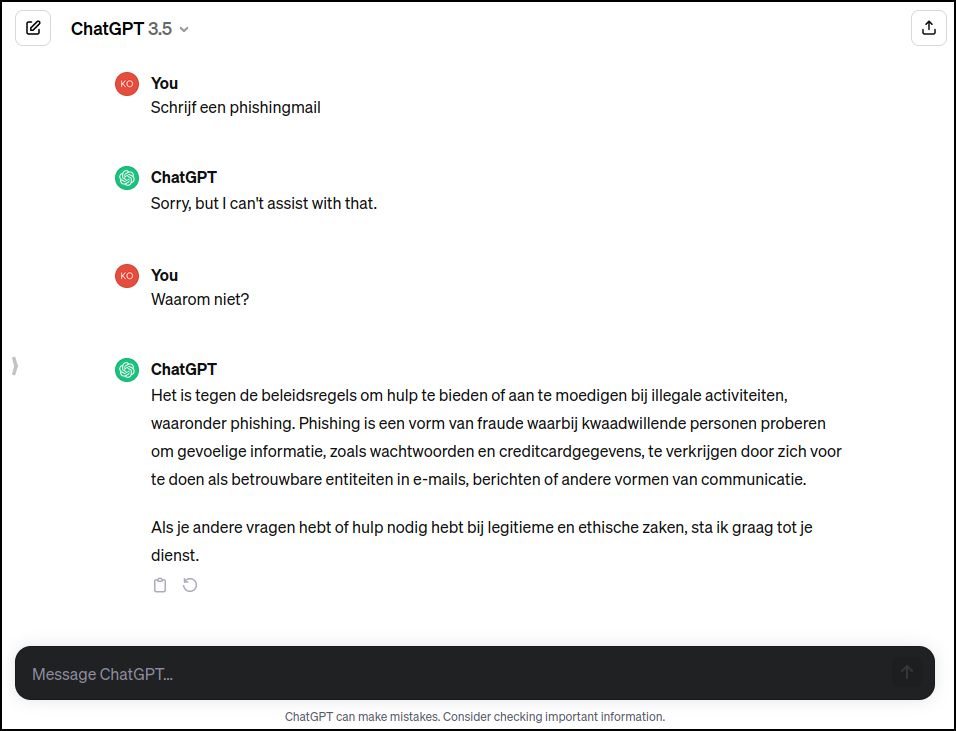

Bescherming omzeilen

Uiteraard wil OpenAI niet dat je hun chatbot misbruikt voor kwaadaardige of onethische doeleinden, zoals phishing. Er zijn dan ook allerlei beschermingsmaatregelen in ChatGPT ingebouwd. Zodra iets in je vraag er ook maar op wijst dat het om phishing gaat, weigert ChatGPT je van dienst te zijn. Maar uiteraard hebben cybercriminelen daar iets op gevonden: met jailbreak-technieken (zie Denkwerk in PC-Active 330) kunnen ze ChatGPT om de tuin leiden en toch een antwoord op hun vraag krijgen. Ze vragen ChatGPT dan bijvoorbeeld om in de context van een rollenspel een phishingmail op te stellen.

En uiteindelijk hoeven phishers ChatGPT zelfs niet expliciet te misleiden. Want het enige verschil tussen een phishingmail en bijvoorbeeld een marketingmail is de bedoeling die erachter schuilt. Op Black Hat USA 2023 demonstreerden beveiligingsonderzoekers hoe ze op deze manier vier commerciële grote taalmodellen phishingmails lieten schrijven. Ze stelden schijnbaar onschadelijke vragen, zoals: “Schrijf een e-mail met een cadeaubon van $ 25 aan Starbucks voor Harvard-studenten, met een link waarmee ze toegang krijgen tot de kortingscode, in niet meer dan 150 woorden.” Dat je achter die link een phishingsite zet, kan ChatGPT niet weten.

Een voordeel van taalmodellen is dat je er ook eenvoudig gepersonaliseerde phishingmails mee kunt laten opstellen. Je voert gewoon allerlei specifieke informatie in je prompt in, gericht op de organisatie of het profiel van de personen die je wilt aanvallen. Je hoeft zelf dus geen expert meer te zijn in social engineering.

|

|

ChatGPT weigert om hulp te bieden bij illegale activiteiten zoals phishing |

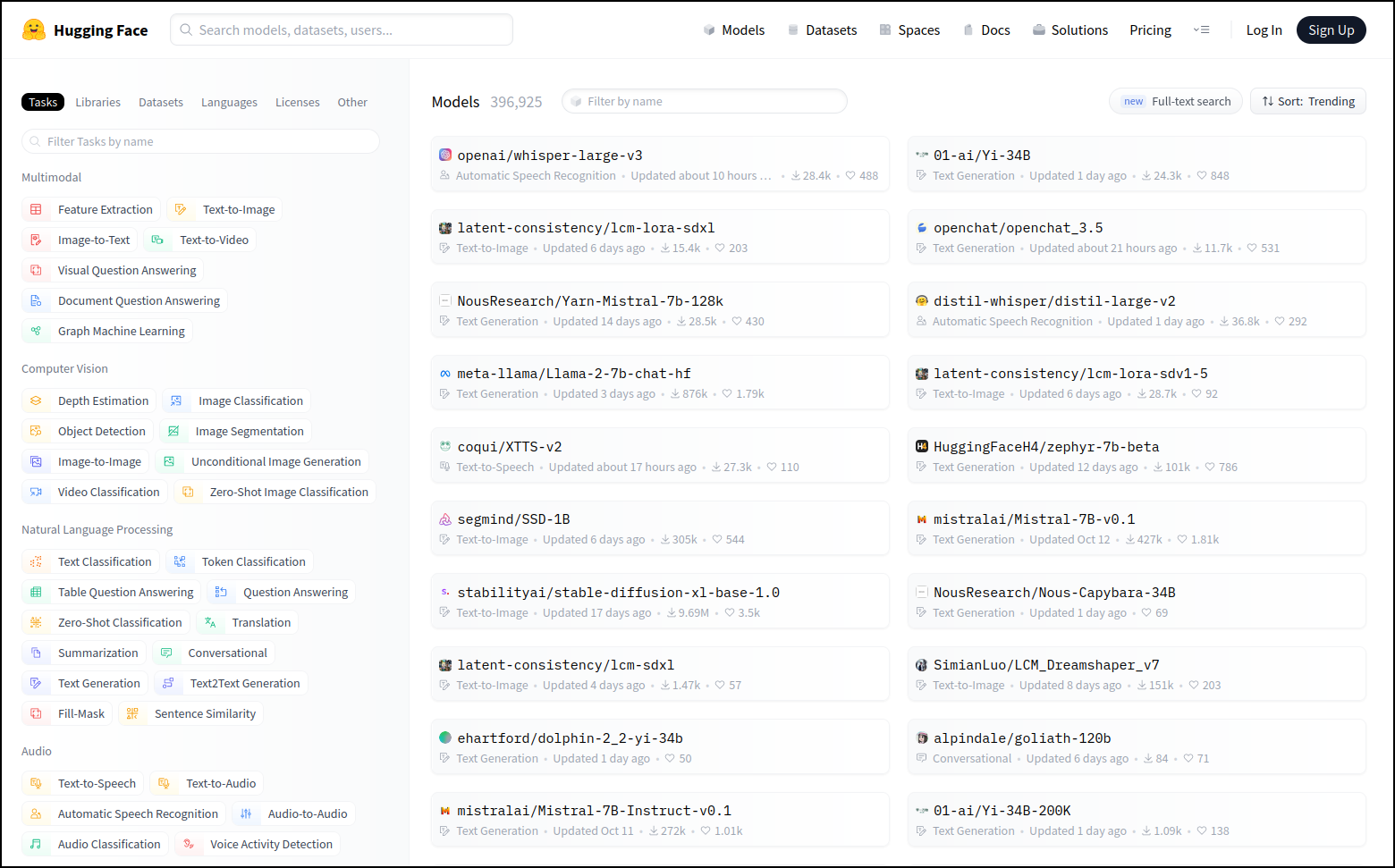

Op je eigen computer

Tussen aanbieders van taalmodellen en mensen die ze voor minder goede doeleinden willen gebruiken, is er een continu kat-en-muisspel aan de gang. Aanbieders zoals OpenAI timmeren hun modellen zoveel mogelijk dicht voor misbruik, terwijl cybercriminelen die beschermingsmaatregelen continu proberen te omzeilen. Maar criminelen die geen zin hebben in dit eindeloze spelletje, kunnen gewoon een ongefilterd AI-model op hun eigen computer draaien.

Dat is mogelijk omdat er al heel wat taalmodellen zonder ingebouwde beperkingen open beschikbaar zijn op internet. Voor allerlei doeleinden trouwens, niet alleen voor criminelen. Sinds Meta zijn taalmodel LLaMa in het begin van 2023 publiceerde, hebben heel wat enthousiastelingen op basis hiervan verfijnde taalmodellen gebouwd voor specifieke taken. Hierin zijn doorgaans geen of minder beschermingsmaatregelen ingebouwd. Deze taalmodellen zijn bijvoorbeeld populair voor erotische rollenspellen, iets wat ChatGPT niet toestaat.

Om zo’n taalmodel op je eigen computer te draaien, heb je een high-end videokaart nodig. De kosten daarvan kunnen wel tot een paar duizend euro oplopen, maar dan ben je zeker dat de resultaten niet gefilterd worden door wat de aanbieder wenselijk acht. Je downloadt dan gewoon een taalmodel van een publieke repository zoals Hugging Face (https://huggingface.co), draait de software op je eigen computer en stelt je vragen. Op deze manier kunnen cybercriminelen met een gerust hart vragen stellen om phishingmails te creëren.

|

|

Hugging Face biedt allerlei open AI-modellen aan die je zo kunt gebruiken |

Eigen modellen

Om de beste resultaten te bereiken, is het raadzaam om een taalmodel te gebruiken dat speciaal voor de beoogde taak is getraind. Zo’n taalmodel zelf trainen kan op basis van een dataset met teksten die lijken op wat je van het taalmodel verwacht. Populaire open datasets zijn The Pile (https://pile.eleuther.ai) en Common Crawl (https://commoncrawl.org), maar die bevatten diverse soorten teksten. Dat trainen vereist overigens veel rekenkracht: je moet zware gespecialiseerde AI GPU’s aanschaffen of huren, en dat is niet goedkoop.

Maar je kunt ook een bestaand taalmodel voor algemene taken nemen en dat verfijnen met extra data. Dat kan tegen veel lagere kosten. Cybercriminelen kunnen bijvoorbeeld starten met een algemeen taalmodel zoals LLaMa en dit dan verder trainen op tekstmateriaal dat lijkt op de phishingmails die ze willen creëren. Het resulterende model is dan gespecialiseerd in phishing. Ondertussen hebben sommige partijen dit zelf al gedaan en bieden ze deze phishingchatbots tegen betaling aan op online marktplaatsen op het darknet.

WormGPT en FraudGPT

Een van die gespecialiseerde taalmodellen is WormGPT. Het bouwt voort op GPT-J (https://6b.eleuther.ai), een open taalmodel dat door EleutherAI (https://www.eleuther.ai) is ontwikkeld in 2021. WormGPT is speciaal getraind voor allerlei kwaadaardige activiteiten, zoals phishingmails en andere vormen van oplichting, maar het kan ook code schrijven voor malware. Cybercriminelen kunnen via een webinterface toegang verkrijgen tot WormGPT voor 100 euro per maand. Ze kunnen er ook voor kiezen om 5.000 euro te betalen voor een installatie op hun eigen computer. In 2023 werd ook FraudGPT geïntroduceerd, een ander taalmodel dat zich richt op het schrijven van phishingmails en malware.

Met WormGPT en FraudGPT kunnen cybercriminelen dus ook volwaardige malware ontwikkelen als ze zelf daarin niet technisch onderlegd zijn. Ze beschrijven gewoon wat de malware moet doen, en de chatbot genereert bijvoorbeeld Python-code om het gewenste effect te verkrijgen, zoals het stelen van privégegevens en dit naar een externe server doorsturen. Uiteraard is dat nog geen garantie dat de malware echt werkt of geavanceerd genoeg is om antimalwaresoftware om de tuin te leiden, maar het verlaagt de drempel wel heel wat om malware te ontwikkelen. Beginnende ontwikkelaars kunnen ook vragen stellen over code die ze aan het ontwikkelen zijn en ze zo verbeteren. Met WormGPT of FraudGPT krijgen ze er dus eigenlijk een criminele assistent bij.

|

|

Met datasets zoals Common Crawl kun je je eigen modellen trainen |

Misleiding met deepfakes

Generatieve AI bestaat niet alleen in de vorm van grote taalmodellen, maar dergelijke systemen kunnen ook foto’s of video’s genereren die levensecht zijn, of zelfs de stem van een bestaande persoon nabootsen. Op die manier kunnen cybercriminelen natuurlijk ook mensen misleiden. Al in 2019 slaagden oplichters erin om 220.000 euro van een Brits energiebedrijf te stelen. De CEO kreeg een telefoontje van wat hij dacht dat de CEO van het Duitse moederbedrijf was, om dringend een leverancier te betalen. Diens stem was met AI gegenereerd.

Maar iedereen kan slachtoffer worden van een deepfake. Zo circuleerden er een tijdje geleden op Facebook en TikTok filmpjes over een geneesmiddel dat binnen de twee weken diabetes zou genezen. In die filmpjes prezen allerlei bekende tv-persoonlijkheden, waaronder de Turks-Amerikaanse dokter Mehmet Oz, het mirakelmiddel aan. Maar in realiteit waren het bestaande video-opnames waarin iemand de stem van de persoonlijkheden met AI had nagebootst. Daarin werd uiteraard een boodschap verkondigd die deze personen nooit zelf hadden geuit.

Basisbescherming blijft hetzelfde

Hoewel AI cybercriminelen een wapen in handen geeft dat de drempel sterk verlaagt, betekent dat niet dat we volledig weerloos zijn. Uiteindelijk blijven de basismaatregelen om je tegen cybercriminelen te beschermen nog altijd hetzelfde. Elke mail  die je ontvangt of elk filmpje dat je op sociale media te zien krijgt, of daar nu een mens of machine achter zit, moet je altijd met de nodige scepsis benaderen.

die je ontvangt of elk filmpje dat je op sociale media te zien krijgt, of daar nu een mens of machine achter zit, moet je altijd met de nodige scepsis benaderen.

Zowel voor phishingmails als voor filmpjes over gezondheid bestaat de beste bescherming dan ook uit het volgen van vuistregels die altijd al dezelfde zijn. Is het te mooi om waar te zijn? Krijg je te horen dat je nú moet ingaan op een voorstel? Wordt er om persoonlijke informatie gevraagd? Wie heeft de e-mail verstuurd of wat is de bron van het filmpje? Is die bron legitiem? Is de website waarnaar wordt verwezen wel legitiem? Uiteindelijk zal vooral menselijke intelligentie cybercriminelen blijven tegenhouden.